目次

気候変動を食い止めるための世界的な取り組みの中で、ザック・スミス氏(Zac Smith)は、高性能とエネルギー効率の両方を提供するデータセンターの構築という、成長中のムーブメントに関わっている。彼は、240を超えるデータセンターを管理するグローバルサービスプロバイダーであるEquinixのエッジインフラストラクチャの責任者であり、本セクターで初めてクライメイトニュートラル(気候中立)になることを約束している。

「私たちには、この旅の手助けを求め、頼りにされている1万人の顧客がいます。彼らはより多くのデータとインテリジェンスをほとんどの場合AIと共に要求し、それらを持続可能な方法により望んでいます」と語るスミス氏は、ジュリアード音楽院の卒業生であり、2000年代初頭にニューヨークのミュージシャン仲間のためにウェブサイトを構築し技術畑に進んだ経歴を持つ。

効率面での進歩

4月の時点で、Equinixは49億ドルのグリーンボンドを発行している。これらは、Equinixが、データセンターが使用するエネルギーのどれだけがコンピューティングタスクに直接使用されるかを示す業界指標である電力使用効率(PUE)を最適化することにより、環境への影響を軽減するために適用される投資適格債である。

データセンターのオペレーターは、その比率を理想の1.0 PUEにさらに近づけようとしている。Equinixの施設の現在の平均PUEは1.48 PUEであり、その最高の新しいデータセンターでは1.2未満を記録している。

もうひとつの前進として、Equinixは1月に、エネルギー効率の向上を追求するための専用施設を開設した。その作業の一部は、液体冷却に焦点を当てている。

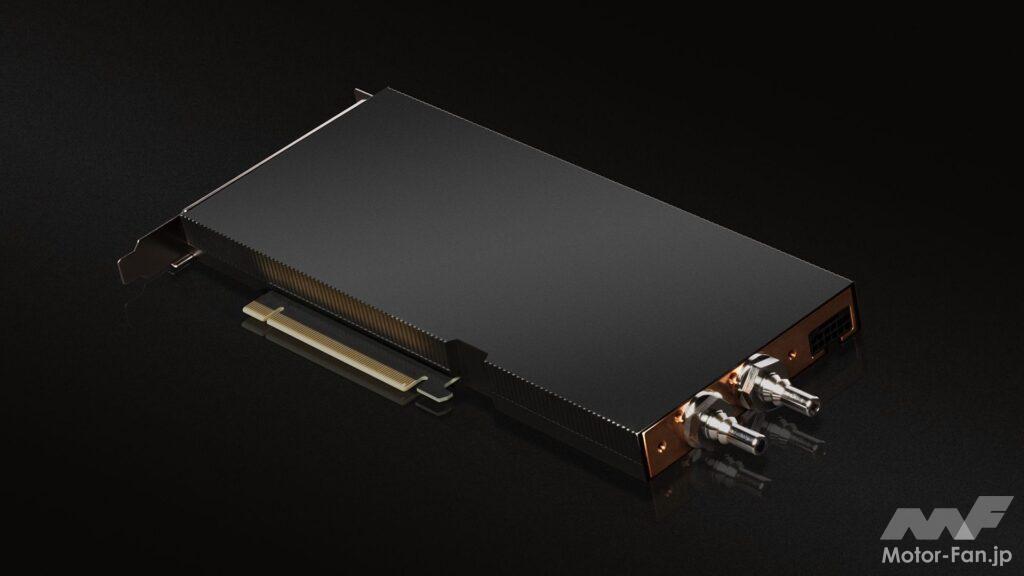

メインフレームの時代に生まれた液体冷却は、AIの時代に成熟しつつある。現在、ダイレクトチップ冷却と呼ばれる最新の方式で、世界最速のスーパーコンピューター内で広く使用されている。

液体冷却は、CPUよりもAI推論で最大20倍優れたエネルギー効率をすでに提供しているNVIDIA GPUのアクセラレーテッドコンピューティングの次のステップである。

アクセラレーションによる効率化

世界中でAIを実行しているすべてのCPUのみを搭載したサーバーをGPUアクセラレーテッドシステムに切り替えると、年間11兆ワット時のエネルギーを節約できる。これは、年間150万世帯が消費するエネルギーを節約するのと同じだ。

今日、NVIDIAは、ダイレクトチップ冷却を使用した最初のデータセンターPCIe GPUのリリースにより、持続可能性への取り組みを強化する。

Equinixは、持続可能な冷却と熱回収への包括的なアプローチの一環として、データセンターにA100 80GB PCIe液冷GPU(http://www.nvidia.com/a100)を採用した。このGPUは現在サンプルを提供中であり、今年の夏に一般提供される予定。

水と電力の節約

「これは、Equinixのラボに導入された最初の液冷GPUであり、お客様がAIを活用する持続可能な方法を渇望していることから、私たちにとっても心躍るものです」とスミス氏は述べている。

データセンターのオペレーターは、データセンター内の空気を冷却するために年間数百万ガロンの水を蒸発させる冷却装置を排除することを目指している。液体冷却は、主要なホットスポットに焦点を合わせ、閉じたシステムで少量の液体を循環させるシステムを実現する。

「私たちは廃棄物を資産に変えるのです」とスミス氏は述べている。

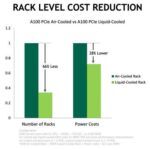

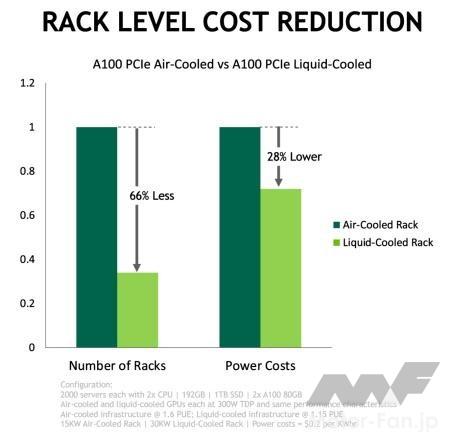

同じパフォーマンスで少ない電力

別々のテストで、EquinixとNVIDIAは、液冷式を採用するデータセンターが約30%少ないエネルギーを使用しながら、空冷施設と同じワークロードを実行できることを発見した。NVIDIAは、液冷式データセンターが1.15 PUEに達する可能性があると推定。これは、空冷式の1.6をはるかに下回る。

液冷式データセンターは、同じスペースに2倍のコンピューティングを詰め込むこともできる。これは、A100 GPUが1つのPCIeスロットのみを使用するため。空冷のA100 GPUは2スロットを占有する。

少なくとも12のシステムメーカーが、今年後半にこれらのGPUを製品に採用することを計画している。この中には、ASUS、ASRock Rack、Foxconn Industrial Internet、GIGABYTE、H3C、Inspur、Inventec、Nettrix、QCT、Supermicro、Wiwynn、xFusionが含まれている。

世界的なトレンド

エネルギー効率基準を設定する規制は、アジア、ヨーロッパ、および米国で検討されている。これにより、銀行やその他の大規模なデータセンター運営者も液体冷却を評価しはじめている。

また、このテクノロジはデータセンターに限定されていない。車やその他のシステムは、限られたスペースに組み込まれた高性能システムを冷却するために、この技術を必要とする。

持続可能性への道

「これは旅の始まりです」と、スミス氏は、主流となるであろうこの液冷式のアクセラレーターのデビューについて述べている。

実際、A100 PCIeカードに続いて、来年NVIDIAはNVIDIA Hopperアーキテクチャ(https://www.nvidia.com/ja-jp/technologies/hopper-architecture/)ベースのH100 TensorコアGPUを搭載したバージョンをリリースする予定。また近い将来、高性能なデータセンターGPUとNVIDIA HGXプラットフォームで液体冷却をサポートする予定。

迅速な採用のために、今日の液冷GPUは、より少ないエネルギーで同等のパフォーマンスを提供する。将来的には、これらのカードが同じエネルギーでより多くのパフォーマンスを得るオプションを提供することを期待している。

「ワット数の測定だけでは意味がありません。炭素への影響に対して得られるパフォーマンスこそが、私たちが目指すべきものなのです」とスミス氏は述べている。

新しいA100 PCIe液冷GPUの詳細については、こちら(https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf)を参照。